"La idea que subyace detrás de ARPA es que la promesa ofrecida por el ordenador como medio de comunicación convierte en insignificante su origen histórico como herramienta de cálculo"

Documentos fundacionales de ARPA (1957)

La evolución tecnológica en los últimos años ha sido completamente vertiginosa, hasta el punto de sacudir los conceptos más básicos. En un contexto que se ha movido a tal velocidad, resulta razonable que incluso personas que se consideran expertos en tecnología o que trabajan con ella en su día a día se encuentren confusos, incapaces de apreciar la magnitud de los cambios.

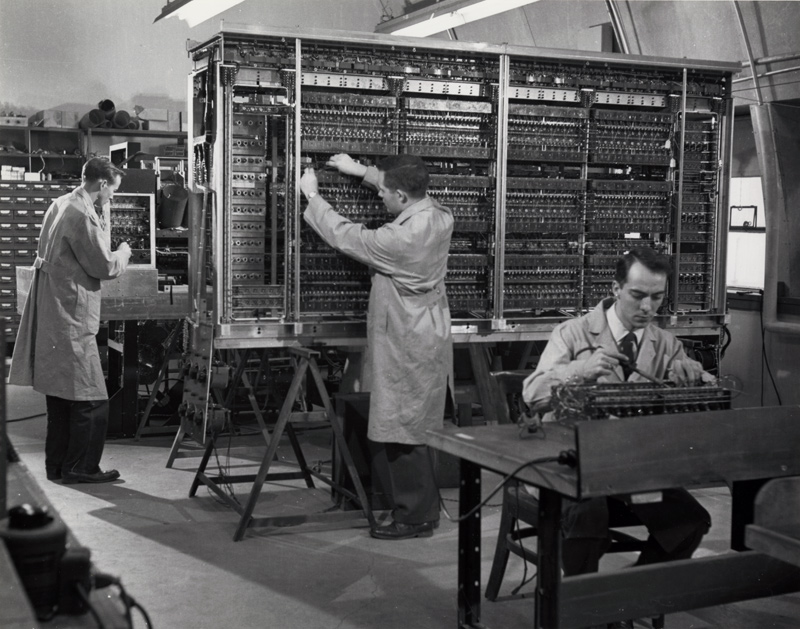

Hace tan solo veinte o veinticinco años, un ordenador era una máquina con un procesador muy inferior en prestaciones al que hoy tiene un teléfono móvil sencillo, y dotado de muchísima menos memoria. Si nos remontamos un poco más en el tiempo, los ordenadores que manejaban las personas no tenía siquiera procesador o memoria: eran los llamados "terminales tontos", que constaban únicamente de una interfaz de uso con pantalla y teclado para acceder a un ordenador central con capacidad de proceso y memoria. La comparación entre un IBM PC de 1981 y un iPhone resultaría casi grotesca: desde el procesador Intel 8088 capaz de correr a 4.77MHz. hasta el de un iPhone 3GS actual, preparado para correr a 833MHz. aunque se utiliza a "tan solo" 600MHz. con el fin de reducir el consumo y la generación de calor, hablamos de una potencia superior en más de cien veces, y estamos comparando un ordenador con un simple teléfono de bolsillo: en el caso de un ordenador de sobremesa comparable, las magnitudes de la comparación son sumamente difíciles de apreciar, por la presencia no solo de incrementos brutales en velocidad, sino también de múltiples núcleos, memorias internas y unidades de procesamiento paralelo. En términos de memoria, el iPhone es capaz de almacenar hasta 32 GB en memoria Flash, frente a un IBM PC que carecía de disco duro y que únicamente permitía trabajar con dos diskettes de cinco pulgadas y cuarto, de 360KB cada uno. Si comparásemos uno de los primeros ordenadores, el construido en el Massachusetts Institute of Technology (MIT) en 1965, con un teléfono móvil actual, nos encontraríamos con un dispositivo que, puesto en números redondos, es alrededor de mil veces más potente, cien mil veces más pequeño, y un millón de veces más barato. Una comparación de magnitudes sencillamente mareante, que nos da idea del brutal avance de la tecnología en el tiempo.

Pero más allá de la evolución de las capacidades tecnológicas, resulta interesante pensar en otro cambio de concepto si cabe más importante: ¿para qué tipo de tareas utilizábamos un ordenador entonces? Por regla general, el usuario de un IBM PC podía, en su vertiente más seria, utilizar un proceso de textos como WordStar, una hoja de cálculo como Lotus 1,2,3 y un programa de gráficos como Harvard Graphics, por no mencionar bases de datos como dBASE y otros programas como compiladores, etc. de un uso generalmente más técnico.

Puestos a analizar el tipo de tareas que se llevaban a cabo, podríamos decir que un proceso de textos viene a ser como una máquina de escribir en edición corregida y mejorada: su metodología permite disociar la fase de introducción de texto de la representación del mismo sobre un papel, lo que permite una productividad muy superior. En lugar de escribir una carta cada vez que aparece directamente sobre el papel y nos obliga a recurrir al popular Tipp-ex para enmendar posibles errores, el procesador de textos permite componer un texto en pantalla, e imprimirlo todas las veces que queramos, con posibles cambios y correcciones parciales. Sin duda, el proceso de textos representaba un enorme avance en productividad. El análisis de una hoja de cálculo nos llevaría prácticamente a las mismas conclusiones: en realidad, se trata básicamente de una "calculadora con esteroides" capaz de almacenar en su memoria una cantidad casi ilimitada de operaciones encadenadas, algo que indudablemente nos permite multiplicar nuestra eficiencia cuando trabajamos con números. Pero, yéndonos a la esencia de la cuestión: ¿qué es lo que realmente cambia entre máquina de escribir y proceso de textos, entre calculadora de bolsillo y hoja de cálculo? A todos los efectos, un ordenador se consideraba una máquina destinada a hacer lo mismo que haríamos sin ella, pero mucho más rápido, con una mayor eficiencia.

Puestos a analizar el tipo de tareas que se llevaban a cabo, podríamos decir que un proceso de textos viene a ser como una máquina de escribir en edición corregida y mejorada: su metodología permite disociar la fase de introducción de texto de la representación del mismo sobre un papel, lo que permite una productividad muy superior. En lugar de escribir una carta cada vez que aparece directamente sobre el papel y nos obliga a recurrir al popular Tipp-ex para enmendar posibles errores, el procesador de textos permite componer un texto en pantalla, e imprimirlo todas las veces que queramos, con posibles cambios y correcciones parciales. Sin duda, el proceso de textos representaba un enorme avance en productividad. El análisis de una hoja de cálculo nos llevaría prácticamente a las mismas conclusiones: en realidad, se trata básicamente de una "calculadora con esteroides" capaz de almacenar en su memoria una cantidad casi ilimitada de operaciones encadenadas, algo que indudablemente nos permite multiplicar nuestra eficiencia cuando trabajamos con números. Pero, yéndonos a la esencia de la cuestión: ¿qué es lo que realmente cambia entre máquina de escribir y proceso de textos, entre calculadora de bolsillo y hoja de cálculo? A todos los efectos, un ordenador se consideraba una máquina destinada a hacer lo mismo que haríamos sin ella, pero mucho más rápido, con una mayor eficiencia.

El verdadero cambio se llamaba productividad. Entendida simplemente como producción por unidad de tiempo, la productividad era visto como el argumento fundamental para la adopción de tecnología, y lo fue por supuesto en el caso de los ordenadores y sus primeros clientes, las empresas. Si pensamos en las primeras áreas funcionales de las empresas que en su momento decidieron incorporar ordenadores, nos encontramos en una amplia mayoría de casos con Contabilidad y Finanzas, áreas en las que no solo se precisaba un intenso tratamiento y análisis de datos que resultaba además muy repetitivo, sino que, además, existía un requisito legal de almacenamiento de los mismos. Otras áreas, tales como Recursos Humanos, contaban también con procesos, como el cálculo de nóminas, altamente cíclicos y repetitivos, que podían beneficiarse en gran medida del poder de cálculo de los ordenadores. Su incorporación posibilitaba la programación de las secuencias de trabajos, que tras la introducción de los datos, pasaban a un tratamiento automatizado que se desarrollaba a mucha mayor velocidad. Como en el caso de la productividad personal, un ordenador era para la empresa una máquina para llevar a cabo esencialmente los mismos procesos, pero a mayor velocidad.

Para muchas, muchísimas personas y empresas, un ordenador sigue siendo exactamente lo mismo: una máquina para desarrollar las mismas tareas, pero más rápido. En realidad, la productividad de los ordenadores se manifestaba en muchos más aspectos: poder calcular más rápido en una hoja de cálculo no permitía simplemente terminar la tarea antes, sino que proporcionaba además una capacidad analítica derivada del hecho de poder visualizar más escenarios, hacer más hipótesis o llevar a cabo más pruebas que acababa redundando en una comprensión del problema muy superior.

Pero más allá de estas ganancias incrementales, consideremos ahora los tiempos en que vivimos: ¿cuál diríamos que es, en este momento, la pieza más importante de su ordenador de sobremesa? ¿Qué parte del ordenador de su despacho le hace pensar en volverse a su casa cuando no funciona? La respuesta es clara: la parte más importante de su ordenador de sobremesa está por detrás: es su cable de red. Si la red no funciona, usted mirará lastimeramente a la máquina, y pensará eso de "me voy a tomar un café, el ordenador no funciona". En realidad, la máquina funciona perfectamente, es la conexión a la red la que no lo hace. ¿Qué nos lleva a tener esa sensación de que la máquina no sirve para nada cada vez que la red se cae? ¿Qué programas tenemos más tiempo hoy en día delante de nuestros ojos en la pantalla? Salvo casos muy específicos, la respuesta para la mayoría de usuarios será que los programas que acaparan la pantalla durante más tiempo son el gestor de correo electrónico, la mensajería instantánea y, sobre todo y cada vez de manera más patente, la gran estrella: el navegador. En muy pocos años, el ordenador ha pasado de ser una máquina destinada a la productividad, una herramienta para hacer lo mismo pero más rápido, a ser una ventana abierta al mundo, el punto a través del cual nos comunicamos, nos relacionamos, recibimos y enviamos información.

Pero más allá de estas ganancias incrementales, consideremos ahora los tiempos en que vivimos: ¿cuál diríamos que es, en este momento, la pieza más importante de su ordenador de sobremesa? ¿Qué parte del ordenador de su despacho le hace pensar en volverse a su casa cuando no funciona? La respuesta es clara: la parte más importante de su ordenador de sobremesa está por detrás: es su cable de red. Si la red no funciona, usted mirará lastimeramente a la máquina, y pensará eso de "me voy a tomar un café, el ordenador no funciona". En realidad, la máquina funciona perfectamente, es la conexión a la red la que no lo hace. ¿Qué nos lleva a tener esa sensación de que la máquina no sirve para nada cada vez que la red se cae? ¿Qué programas tenemos más tiempo hoy en día delante de nuestros ojos en la pantalla? Salvo casos muy específicos, la respuesta para la mayoría de usuarios será que los programas que acaparan la pantalla durante más tiempo son el gestor de correo electrónico, la mensajería instantánea y, sobre todo y cada vez de manera más patente, la gran estrella: el navegador. En muy pocos años, el ordenador ha pasado de ser una máquina destinada a la productividad, una herramienta para hacer lo mismo pero más rápido, a ser una ventana abierta al mundo, el punto a través del cual nos comunicamos, nos relacionamos, recibimos y enviamos información.

El cambio tiene una magnitud tan brutal, tan importante, como lo que supondría que, en pocos años, los automóviles dejasen de ser máquinas que nos llevan de un lado a otro y pasasen a ser utilizados fundamentalmente para calentar café: algo completamente impensable. Pero está sucediendo, y a una velocidad enorme: cada vez más, el navegador toma una preponderancia mayor, y va acaparando progresivamente una mayor cantidad de nuestras tareas habituales. Los navegadores se sofistican: se dotan de pestañas múltiples que permiten desempeñar varias tareas a la vez, adquieren nuevas funciones gracias al desarrollo de extensiones, y comienza una carrera competitiva por la cuota de mercado de los mismos que incluye a jugadores como el Internet Explorer de Microsoft, que poseía la mayor cuota de mercado, y otros más rápidos y pujantes en su desarrollo, como el Firefox de la Mozilla Foundation, heredero del antiguo Netscape, o jugadores interesantes como Apple (Safari), Opera, o Google (Chrome). Cada vez más, el navegador, unido a unos servicios en la red cada vez más avanzados, van haciendo que el ordenador sea menos relevante: para ejecutar un navegador y utilizar servicios online, no es necesaria una gran potencia en la máquina, lo que altera el panorama competitivo en la venta de hardware: por primera vez, el avance de la tecnología no implica necesariamente adquirir un ordenador nuevo, sino que puede llevarse a cabo sobre máquinas que incrementan su vida útil notablemente, acercándose a lo que debería ser su ciclo de funcionamiento razonable. Un ordenador, encendido casi a todas horas de manera continua, puede llegar a durar, en función de la calidad de sus componentes, unos seis o siete años, y podría seguir funcionando tras la sustitución selectiva de algunos componentes. Sin embargo, los usuarios estaban acostumbrados a un panorama en el que cada tres años como media, era preciso cambiar de ordenador si se quería instalar la última versión de sistema operativo, y no hacerlo significaba quedarse desactualizado y empezar a recibir archivos en formatos que no se podían abrir.

El cambio tiene una magnitud tan brutal, tan importante, como lo que supondría que, en pocos años, los automóviles dejasen de ser máquinas que nos llevan de un lado a otro y pasasen a ser utilizados fundamentalmente para calentar café: algo completamente impensable. Pero está sucediendo, y a una velocidad enorme: cada vez más, el navegador toma una preponderancia mayor, y va acaparando progresivamente una mayor cantidad de nuestras tareas habituales. Los navegadores se sofistican: se dotan de pestañas múltiples que permiten desempeñar varias tareas a la vez, adquieren nuevas funciones gracias al desarrollo de extensiones, y comienza una carrera competitiva por la cuota de mercado de los mismos que incluye a jugadores como el Internet Explorer de Microsoft, que poseía la mayor cuota de mercado, y otros más rápidos y pujantes en su desarrollo, como el Firefox de la Mozilla Foundation, heredero del antiguo Netscape, o jugadores interesantes como Apple (Safari), Opera, o Google (Chrome). Cada vez más, el navegador, unido a unos servicios en la red cada vez más avanzados, van haciendo que el ordenador sea menos relevante: para ejecutar un navegador y utilizar servicios online, no es necesaria una gran potencia en la máquina, lo que altera el panorama competitivo en la venta de hardware: por primera vez, el avance de la tecnología no implica necesariamente adquirir un ordenador nuevo, sino que puede llevarse a cabo sobre máquinas que incrementan su vida útil notablemente, acercándose a lo que debería ser su ciclo de funcionamiento razonable. Un ordenador, encendido casi a todas horas de manera continua, puede llegar a durar, en función de la calidad de sus componentes, unos seis o siete años, y podría seguir funcionando tras la sustitución selectiva de algunos componentes. Sin embargo, los usuarios estaban acostumbrados a un panorama en el que cada tres años como media, era preciso cambiar de ordenador si se quería instalar la última versión de sistema operativo, y no hacerlo significaba quedarse desactualizado y empezar a recibir archivos en formatos que no se podían abrir.

Además, los usuarios van pasando de escenarios tecnológicos en los que utilizaban un solo ordenador, a otros en los que pasan a utilizar varios terminales de diversos tipos: los casos en los que una persona utiliza un ordenador en su casa, otro en su despacho, un ordenador portátil cuando viaja y un teléfono móvil con capacidad de conexión empiezan a ser más norma que excepción, y definen casuísticas en las que el mejor escenario consiste en tener los datos en un repositorio central en la red, al que se puede acceder desde cada una de las máquinas sin necesidad de duplicar innecesariamente los archivos.

Además, los usuarios van pasando de escenarios tecnológicos en los que utilizaban un solo ordenador, a otros en los que pasan a utilizar varios terminales de diversos tipos: los casos en los que una persona utiliza un ordenador en su casa, otro en su despacho, un ordenador portátil cuando viaja y un teléfono móvil con capacidad de conexión empiezan a ser más norma que excepción, y definen casuísticas en las que el mejor escenario consiste en tener los datos en un repositorio central en la red, al que se puede acceder desde cada una de las máquinas sin necesidad de duplicar innecesariamente los archivos.

En estas condiciones, en 2007, la empresa taiwanesa Asus decide lanzar su serie Eee: la denominación correspondía a "Easy to learn, Easy to work, Easy to play", y era pequeña, ligera, con sistema operativo Linux, y costaba únicamente unos doscientos dólares. La pequeña Asus Eee fue un enorme éxito de ventas, y se convirtió rápidamente la máquina a la que corresponde el honor de inaugurar toda una nueva categoría, la de los denominados ultraportátiles o netbooks, a la que rápidamente se apuntaron muchas otras marcas como Acer, HP o Dell. Durante el año 2008, se vendieron en el mundo dieciséis millones y medio de unidades de ultraportátiles, que pasaron a ser más de treinta y cinco millones en 2009, un crecimiento del 99%, frente a un mercado de portátiles convencionales de ciento treinta millones de unidades completamente estabilizado en crecimiento cero.

En estas condiciones, en 2007, la empresa taiwanesa Asus decide lanzar su serie Eee: la denominación correspondía a "Easy to learn, Easy to work, Easy to play", y era pequeña, ligera, con sistema operativo Linux, y costaba únicamente unos doscientos dólares. La pequeña Asus Eee fue un enorme éxito de ventas, y se convirtió rápidamente la máquina a la que corresponde el honor de inaugurar toda una nueva categoría, la de los denominados ultraportátiles o netbooks, a la que rápidamente se apuntaron muchas otras marcas como Acer, HP o Dell. Durante el año 2008, se vendieron en el mundo dieciséis millones y medio de unidades de ultraportátiles, que pasaron a ser más de treinta y cinco millones en 2009, un crecimiento del 99%, frente a un mercado de portátiles convencionales de ciento treinta millones de unidades completamente estabilizado en crecimiento cero.

¿Cuál es la razón para el brusco incremento de popularidad de una gama de ordenadores menos potente que la existente, con teclados en los que es preciso teclear con las puntas de los dedos y pantallas menores de diez pulgadas? Los ultraportátiles resultan notablemente incómodos para trabajar un tiempo prolongado con respecto a un portátil o sobremesa convencional, pero cuestan entre cuatro y ocho veces menos, y tienen un planteamiento muy diferente al de éstos: de hecho, quien adquiere un ultraportátil pensando que se trata simplemente de "un ordenador pequeñito" suele acabar frustrado, porque el concepto es completamente diferente. La idea de un ultraportátil, todavía no completamente llevada a la práctica, es la de ofrecer una máquina que arranca en segundos al abrir su tapa, que tiene un sistema operativo completamente minimalista, seguro y a prueba de bomba en su estabilidad, y que es capaz de detectar el estado de conexión del momento: si está en una zona con conectividad inalámbrica en abierto o en una red de la que tiene la clave, se conecta automáticamente. De no ser así, lanza la conexión telefónica con el operador correspondiente a la tarjeta que lleve puesta (muchas de estas máquinas se venden subvencionadas en conjunción con un contrato de telefonía ligado a un compromiso de permanencia determinado). Y en caso de interrupción de la conexión, trabajan sobre el almacenamiento de la máquina (habitualmente, una tarjeta de memoria Flash) de manera temporal utilizando como referencia la última copia sincronizada hasta que recuperan la conexión, momento en el cual vuelven a sincronizar los cambios. Se trata de máquinas que no tienen sentido sin la red, sin la llamada "nube": trabajan sobre servicios provistos por empresas que, a cambio de un pago periódico o de la provisión de publicidad, proporcionan al usuario tanto una aplicación determinada como el espacio de almacenamiento necesario para guardar los archivos del usuario.

Las primeras aplicaciones de este tipo que empezaron a ganar popularidad lo hicieron a nivel de usuarios particulares, no de empresa. El caso de Gmail, el correo electrónico de Google, fue especialmente interesante: en un mercado dominado por proveedores como Hotmail o Yahoo! Mail, que ofrecían en sus versiones gratuitas unos pocos megas de espacio de almacenamiento y no permitían ficheros adjuntos grandes, apareció de repente un competidor, Gmail, que ofrecía nada menos que un giga de espacio de almacenamiento y ficheros adjuntos de un tamaño muy elevado. El servicio, que se ofrecía únicamente en beta cerrada y por invitación, comenzó a crecer muy rápidamente en popularidad: los que lo usaban, se daban cuenta de que era diferente. Al tener una disponibilidad de espacio tan elevada, los usuarios dejaban simplemente de borrar correos, y se dedicaban a almacenarlo todo salvo lo puramente prescindible, apoyándose en el hecho de que la búsqueda permitía encontrar cualquier correo en cuestión de segundos recordando únicamente algún detalle del mismo. El crecimiento en popularidad de Gmail fue muy rápido, y forzó de manera casi inmediata cambios en las ofertas de los otros competidores para intentar que el ridículo al que les había sometido con su llegada al mercado durase un poco menos. Desde el momento de su lanzamiento, que Google hizo coincidir, en un guiño humorístico, con el día 1 de Abril, April Fools, de 2004 (el equivalente en el mundo anglosajón al día de los Santos Inocentes), Gmail tardó hasta Febrero de 2007 en abrir el servicio al público en general, pero en Julio de 2009 alcanzaba ya los ciento cuarenta y seis millones de usuarios en todo el mundo.

Las primeras aplicaciones de este tipo que empezaron a ganar popularidad lo hicieron a nivel de usuarios particulares, no de empresa. El caso de Gmail, el correo electrónico de Google, fue especialmente interesante: en un mercado dominado por proveedores como Hotmail o Yahoo! Mail, que ofrecían en sus versiones gratuitas unos pocos megas de espacio de almacenamiento y no permitían ficheros adjuntos grandes, apareció de repente un competidor, Gmail, que ofrecía nada menos que un giga de espacio de almacenamiento y ficheros adjuntos de un tamaño muy elevado. El servicio, que se ofrecía únicamente en beta cerrada y por invitación, comenzó a crecer muy rápidamente en popularidad: los que lo usaban, se daban cuenta de que era diferente. Al tener una disponibilidad de espacio tan elevada, los usuarios dejaban simplemente de borrar correos, y se dedicaban a almacenarlo todo salvo lo puramente prescindible, apoyándose en el hecho de que la búsqueda permitía encontrar cualquier correo en cuestión de segundos recordando únicamente algún detalle del mismo. El crecimiento en popularidad de Gmail fue muy rápido, y forzó de manera casi inmediata cambios en las ofertas de los otros competidores para intentar que el ridículo al que les había sometido con su llegada al mercado durase un poco menos. Desde el momento de su lanzamiento, que Google hizo coincidir, en un guiño humorístico, con el día 1 de Abril, April Fools, de 2004 (el equivalente en el mundo anglosajón al día de los Santos Inocentes), Gmail tardó hasta Febrero de 2007 en abrir el servicio al público en general, pero en Julio de 2009 alcanzaba ya los ciento cuarenta y seis millones de usuarios en todo el mundo.

La popularidad de Gmail hizo que muchos usuarios empezasen a plantearse que cuando utilizaban el correo gratuito de Google, se encontraban muchas mejores prestaciones que al recurrir a sus cuentas de correo corporativas. En general, Gmail presentaba estadísticas de disponibilidad mucho mejores que cualquier correo gestionado por una empresa, mejor seguridad, mejor filtro antispam (los filtros antispam de Gmail son colaborativos, de manera que cada usuario "enseña" al sistema y éste acaba detectando la gran mayoría del spam de manera automática) y, sobre todo, mejor accesibilidad, particularmente desde dispositivos móviles. La experiencia de uso llevó a un número cada vez mayor de directivos a introducir reglas de redirección permanente en sus correos corporativos, reenviándolos a sus cuentas de Gmail personales. Los responsables de tecnología de las empresas se rasgaban las vestiduras: ¿cómo puedes manejar la información sensible de la empresa en una cuenta externa y gratuita? Y sin embargo, el resultado era contundente: no solo no planteaba problemas de seguridad, sino que ofrecía mejores prestaciones.

Tras Gmail, Google fue ofreciendo progresivamente otras prestaciones, tales como agenda y, finalmente, documentos. La funcionalidad de Google Docs eran sumamente simples en comparación con un programa de ofimática convencional (el 90% del mercado de las suites ofimáticas estaba dominado por el Office de Microsoft), pero... ¿qué porcentaje de las funcionalidades de una suite ofimática utilizaban realmente los usuarios? Las estadísticas afirmaban que dicho porcentaje se encontraba por debajo del 5%: la mayor parte de los usuarios tecleaban textos, los imprimían o enviaban, modificaban algún formato como tipo de letra, negrita, cursiva o subrayado, y poco más. Pero la diferencia a la hora de trabajar en grupo resultaba contundente: mientras los usuarios de Office se tenían que enfrentar a un "control de cambios" completamente enervante e incómodo en su uso, los de Google Docs simplemente invitaban a sus colaboradores mediante correo electrónico, y trabajaban todos ellos sobre el mismo documento, contando incluso con una ventana de mensajería instantánea para coordinarse. Y sobre todo, surgía una gran ventaja: en la metodología convencional, cuando dos personas trabajaban juntas, se generaba una dinámica de envío de versiones que acababa resultando sumamente engorrosa: cada usuario enviaba no el documento, sino una copia del mismo, copia innecesaria y que introducía una nueva versión en estado diferente de actualización a la que cada uno de los miembros del equipo tenía consigo. Esas diferencias incrementales en las versiones provocaban problemas de coherencia, y generaban complejidad. Utilizando un documento online, todos los conflictos de versiones se eliminaban automáticamente: todos los participantes trabajaban sobre un único documento. De hecho, era posible quedarse mirando el documento en la pantalla, y verlo cambiar a medida que otros miembros del equipo iban introduciendo modificaciones en cualquiera de sus partes. A pesar de la sencillez del programa en términos de funcionalidades, la diferencia a la hora de trabajar en grupo era como comparar la edad de piedra y el futuro.

Tras Gmail, Google fue ofreciendo progresivamente otras prestaciones, tales como agenda y, finalmente, documentos. La funcionalidad de Google Docs eran sumamente simples en comparación con un programa de ofimática convencional (el 90% del mercado de las suites ofimáticas estaba dominado por el Office de Microsoft), pero... ¿qué porcentaje de las funcionalidades de una suite ofimática utilizaban realmente los usuarios? Las estadísticas afirmaban que dicho porcentaje se encontraba por debajo del 5%: la mayor parte de los usuarios tecleaban textos, los imprimían o enviaban, modificaban algún formato como tipo de letra, negrita, cursiva o subrayado, y poco más. Pero la diferencia a la hora de trabajar en grupo resultaba contundente: mientras los usuarios de Office se tenían que enfrentar a un "control de cambios" completamente enervante e incómodo en su uso, los de Google Docs simplemente invitaban a sus colaboradores mediante correo electrónico, y trabajaban todos ellos sobre el mismo documento, contando incluso con una ventana de mensajería instantánea para coordinarse. Y sobre todo, surgía una gran ventaja: en la metodología convencional, cuando dos personas trabajaban juntas, se generaba una dinámica de envío de versiones que acababa resultando sumamente engorrosa: cada usuario enviaba no el documento, sino una copia del mismo, copia innecesaria y que introducía una nueva versión en estado diferente de actualización a la que cada uno de los miembros del equipo tenía consigo. Esas diferencias incrementales en las versiones provocaban problemas de coherencia, y generaban complejidad. Utilizando un documento online, todos los conflictos de versiones se eliminaban automáticamente: todos los participantes trabajaban sobre un único documento. De hecho, era posible quedarse mirando el documento en la pantalla, y verlo cambiar a medida que otros miembros del equipo iban introduciendo modificaciones en cualquiera de sus partes. A pesar de la sencillez del programa en términos de funcionalidades, la diferencia a la hora de trabajar en grupo era como comparar la edad de piedra y el futuro.

A medida que la oferta de este tipo de programas "en la nube" crecía, empezó a ponerse de manifiesto que sus necesidades de máquina eran absolutamente espartanas: cualquier ordenador, o incluso un teléfono, capaz de arrancar un navegador servía para acceder a este tipo de funcionalidades. Los ultraportátiles, por tanto, diseñados no para funcionar como un ordenador convencional, sino para trabajar sobre la red, parecían un soporte ideal. Pero ¿es esto una limitación?

En realidad, trabajar sobre la red tiene ventajas muy interesantes: en primer lugar, los archivos del usuario pasan de estar en un disco duro, expuestos a averías, problemas, pérdidas o intrusiones, a estar en un servicio gestionado profesionalmente por especialistas, que pueden ofrecer protocolos de seguridad dotados de una eficiencia muy superior. Intuitivamente, el concepto funciona justo al revés: cualquier persona acostumbrada a pensar en términos analógicos, creerá erróneamente que sus posesiones están más seguras cuanto más cerca las tenga de sí mismo, al alcance de sus ojos. Sin embargo, el concepto es erróneo, como demuestra el hecho de que subcontratemos la custodia de muchos objetos valiosos depositándolos en la caja de seguridad de un banco. Hay muchísimos más robos de propiedades particulares en hogares que en las cajas de seguridad de bancos, que exigen un tipo de preparación muy superior por parte del delincuente. Y la razón por la que no llevamos al banco todas nuestras posesiones es que la caja de seguridad del banco puede ser efectivamente muy segura, pero no es especialmente conveniente: ¿se imagina teniendo que planificar qué ropa, qué reloj o que joyas se pone un día o unos días antes, coincidiendo con los horarios de apertura del banco? En algunos casos, como el de joyas, relojes muy valiosos o documentos de gran importancia, es posible que se haga. Pero en otros, resultaría claramente ineficiente. De la misma manera, mientras no hemos tenido una infraestructura de comunicaciones suficientemente desarrollada, lo razonable era tener el almacenamiento de datos dentro de las empresas, donde podía ser consultado de manera operativa. Pero en el momento en que dicha infraestructura de comunicaciones pasa a ser rápida y a tener una disponibilidad elevada, resulta claro que el mejor lugar para nuestros datos no está en nuestra empresa, que no es especialista en su almacenamiento ni se dedica profesionalmente a ello, sino en un proveedor especializado. De la misma manera, mientras no existió una infraestructura desarrollada para el transporte de agua o electricidad, muchas fábricas cavaban sus propios pozos o contruían minicentrales eléctricas, algo que hoy en día nos resultaría completamente aberrante o que sería incluso ilegal. En el momento en que la madurez de la infraestructura tecnológica lo ha permitido, ha ocurrido lo que era lógico que ocurriese: que la tecnología se ha convertido en algo que, en el momento en que lo necesito, prefiero "abrir un grifo" y que venga desde un proveedor.

Depender de un tercero especializado tiene una serie de implicaciones interesantes: al desarrollarse el mercado de proveedores de servicios de este tipo, pasaremos a tener, como en todo mercado, proveedores buenos, regulares y malos, posiblemente con diferentes precios. La calidad se pacta en un acuerdo de nivel de servicio (Service Level Agreement o SLA), y su incumplimiento conlleva penalizaciones pactadas de acuerdo con el perjuicio producido al cliente. Pero no lo olvide: contrariamente a lo que su intuición analógica le dice, en el mundo digital es imposible que usted, en su empresa dedicada a algún tema no relacionado, tenga mejores protocolos de actualización o seguridad que un proveedor especializado en ello y que aspire a ganar dinero prestando dichos servicios. La nube puede fallar como todo en esta vida, pero su porcentaje de fallos siempre será menor que el de una infraestructura con prestaciones equivalentes mantenida por un no especialista.

Sin embargo, a pesar de las grandes ventajas de funcionalidad, seguridad y prestaciones que este tipo de sistemas generan, el desarrollo de los mismos en el entorno corporativo está siendo relativamente lento: ¿a qué se debe esta lentitud? Recuerde el capítulo dedicado a la resistencia tecnológica: a la presencia de personas en las empresas, particularmente los encargados de gestionar los centros de datos y las infraestructuras tecnológicas corporativas, que se negarán a aceptar las evidencias digan lo que digan los datos. Para el responsable de la informática corporativa, salvo honrosas excepciones, un centro de datos remoto siempre será un peligro para la seguridad, nunca estará tan bien atendido como en la propia empresa y tendrá un nivel de servicio infinitamente inferior. No solo lo afirmará con vehemencia, sino que tendrá varios casos que citar, varias historias para no dormir recogidas de las habladurías y exageraciones de sus compañeros de profesión, que demuestran exactamente lo contrario. La evidencia, simplemente, contradice su experiencia, su aprendizaje, la esencia de su trabajo, el cómo se hacían las cosas antes de que la tecnología cambiase. Y pone decididamente en peligro su puesto de trabajo: ante la externalización de muchos servicios, es indudable que el dimensionamiento de los departamentos de tecnología dentro de las empresas se verá en cierta medida reducido. Algo que no es fácil de aceptar para nadie.

La transición a la nube, por tanto, está determinando la evolución desde sistemas operativos grandes, pesados y cargados de funcionalidades de todo tipo hacia plataformas cada vez más minimalistas que simplemente se utilizan para la interacción básica con los componentes de la máquina, arrancan en cuestión de segundos, y dan paso rápidamente a un navegador en el que el usuario lleva a cabo la mayor parte de su trabajo. A todos los efectos, el cambio de tendencia, el momento culmen de los sistemas operativos de la generación anterior, se produjo con el lanzamiento de Windows Vista. Tras el fracaso de Vista, los sistemas operativos han comenzado una evolución hacia la ligereza, una evolución progresiva hacia el reduccionismo: algunos ultraportátiles llevan versiones de Linux tan aligeradas, que su sistema operativo recuerda al de los teléfonos móviles. De hecho, algunos fabricantes han incorporado en su línea modelos de ultraportátiles que utilizan el sistema operativo Android, desarrollado por Google en conjunción con una plataforma de cuarenta y ocho fabricantes de hardware y software más, precisamente para teléfonos móviles. La propia Google, siendo coherente con la filosofía reduccionista, ha anunciado el lanzamiento de un sistema operativo construido alrededor de su navegador, Chrome: el sistema operativo ya es tan sencillo, que hereda el nombre del navegador que el cliente tiene delante de sus ojos. En no mucho tiempo, el sistema operativo será simplemente algo embebido en los chips de la propia máquina, en la BIOS: la mínima expresión de lo que en su momento se llegó a definir como el componente más estratégico en la relación con el usuario, sobre el que se edificó el dominio de una empresa como Microsoft. Desde el "domina el sistema operativo y dominarás el mundo", a ser un mínimo componente embebido en la BIOS de la máquina. En menos de diez años.

La transición a la nube, por tanto, está determinando la evolución desde sistemas operativos grandes, pesados y cargados de funcionalidades de todo tipo hacia plataformas cada vez más minimalistas que simplemente se utilizan para la interacción básica con los componentes de la máquina, arrancan en cuestión de segundos, y dan paso rápidamente a un navegador en el que el usuario lleva a cabo la mayor parte de su trabajo. A todos los efectos, el cambio de tendencia, el momento culmen de los sistemas operativos de la generación anterior, se produjo con el lanzamiento de Windows Vista. Tras el fracaso de Vista, los sistemas operativos han comenzado una evolución hacia la ligereza, una evolución progresiva hacia el reduccionismo: algunos ultraportátiles llevan versiones de Linux tan aligeradas, que su sistema operativo recuerda al de los teléfonos móviles. De hecho, algunos fabricantes han incorporado en su línea modelos de ultraportátiles que utilizan el sistema operativo Android, desarrollado por Google en conjunción con una plataforma de cuarenta y ocho fabricantes de hardware y software más, precisamente para teléfonos móviles. La propia Google, siendo coherente con la filosofía reduccionista, ha anunciado el lanzamiento de un sistema operativo construido alrededor de su navegador, Chrome: el sistema operativo ya es tan sencillo, que hereda el nombre del navegador que el cliente tiene delante de sus ojos. En no mucho tiempo, el sistema operativo será simplemente algo embebido en los chips de la propia máquina, en la BIOS: la mínima expresión de lo que en su momento se llegó a definir como el componente más estratégico en la relación con el usuario, sobre el que se edificó el dominio de una empresa como Microsoft. Desde el "domina el sistema operativo y dominarás el mundo", a ser un mínimo componente embebido en la BIOS de la máquina. En menos de diez años.

El desplazamiento de muchas actividades a la nube conlleva necesariamente una concentración de los centros de datos. Las empresas que aspiran a ofrecer servicios de este tipo precisan enormes granjas de ordenadores, que son además la parte más crítica e importante de su negocio, el constituyente fundamental del mismo. Centros de datos que deben funcionar con total fiabilidad, con redundancia ante posibles fallos de componentes individuales, y sobre todo, con una eficiencia en costes que jamás se había exigido a instalaciones de este tipo. Para una empresa convencional de cualquier industria, el coste del centro de datos es un número más en una cuenta de gastos generales, y un número que además, por principio, no se toca: a "los informáticos" se les mide por las estadísticas de funcionamiento, por la estabilidad, porque el sistema no se caiga, pero no por el gasto de corriente eléctrica en el que incurran. Para una empresa proveedora de servicios, el gasto energético es el ser o no ser, la posibilidad de ser más competitivo que otros, la esencia de su ventaja competitiva. Una dinámica que nos va a llevar, en muy pocos años, a la desaparición de la inmensa mayoría de los centros de datos corporativos, sustituidos por inmensos centros de datos situados en lugares donde el ahorro energético resulta más propicio: a medida que vayan cayendo los mitos de la inseguridad, el control y la privacidad presas de análisis medianamente serios, solo continuarán manteniendo centros de datos propios aquellas empresas con la escala suficiente como para ser razonablemente competitivas en costes.

La estructura de esos centros de datos también empieza a cambiar como consecuencia de esa búsqueda de la eficiencia: en una sorprendente vuelta de tuerca bastante poco habitual en la historia de la industrialización, el progreso tecnológico se alinea con el respeto al medio ambiente. Y lo que es todavía mejor, no lo hace pretendiendo legar un planeta mejor a nuestros hijos ni haciendo gala de ideas ecologistas o conservacionistas, sino por una razón mucho más fácil de entender: el dinero. La presión por incrementar la eficiencia de los centros de datos y el progresivo aumento de potencia de los ordenadores lleva a la virtualización: en una máquina física que incrementa progresivamente su potencia se establecen un número cada vez mayor de máquinas virtuales, que funcionan sobre la misma infraestructura.

La estructura de esos centros de datos también empieza a cambiar como consecuencia de esa búsqueda de la eficiencia: en una sorprendente vuelta de tuerca bastante poco habitual en la historia de la industrialización, el progreso tecnológico se alinea con el respeto al medio ambiente. Y lo que es todavía mejor, no lo hace pretendiendo legar un planeta mejor a nuestros hijos ni haciendo gala de ideas ecologistas o conservacionistas, sino por una razón mucho más fácil de entender: el dinero. La presión por incrementar la eficiencia de los centros de datos y el progresivo aumento de potencia de los ordenadores lleva a la virtualización: en una máquina física que incrementa progresivamente su potencia se establecen un número cada vez mayor de máquinas virtuales, que funcionan sobre la misma infraestructura.

Virtualizar servidores conlleva multiplicar la capacidad del centro de datos, pero también reducir enormemente las necesidades de recursos físicos, y particularmente de uno de ellos: la refrigeración. En un centro de datos convencional, en torno a la mitad de la energía eléctrica suministrada se dedica a refrigerar las instalaciones mediante aire acondicionado. Virtualizar servidores supone sustituir máquinas físicas por máquinas virtuales, con ratios que comienzan en 4:1 pero van progresando a gran velocidad merced a la implacable Ley de Moore La Ley de Moore predice el incremento de las prestaciones de los ordenadores, y afirma que cada 18 meses se duplica el número de transistores en un circuito integrado. Es una ley basada en la observación, y sus resultados se han cumplido razonablemente bien hasta el momento. Tener varios ordenadores virtuales sobre uno físico implica no solo utilizar una sola fuente de alimentación, sino tener además una mayor facilidad a la hora, por ejemplo, de duplicar esa máquina, copiarla o trasladarla a otra localización para incrementar la flexibilidad o responder a una emergencia.

Además de la virtualización, un amplio abanico de tecnologías que van desde el uso de aire exterior en climas fríos hasta el uso de ordenadores con formas que permitan una mejor evacuación del calor (los denominados "blades" en lugar de los típicos "pizza boxes", entre muchas otras innovaciones) o la centralización de componentes como los sistemas de alimentación ininterrumpida han dado lugar a una carrera por la eficiencia energética que, unida a iniciativas como el incremento de la reciclabilidad de los componentes y el uso de materiales más ecológicos en la fabricación definen la llamada Green IT, tecnología verde. El ratio más habitual utilizado para medir la eficiencia energética es el conocido como PUE (Power Use Efficiency, o Eficiencia en el uso de electricidad), que representa la potencia que hay que suministrar a un centro de datos para llegar a suministrar un vatio al ordenador, y suele oscilar, en centros de datos de construcción antigua, en valores superiores a 2: por cada vatio que llega al ordenador y se convierte en potencia de computación, ha sido necesario suministrar al centro de datos dos vatios, uno de los cuales se ha perdido en refrigeración, elementos de conexión, sistemas de alimentación ininterrumpida, etc. Frente a las intenciones de la Agencia de Protección Ambiental de los Estados Unidos de imponer un PUE inferior a 1.9 para el año 2013, algunas empresas como Google han llegado, en esta carrera por la eficiencia a obtener en sus enormes centros de datos, a valores de PUE de entre 1.13 y 1.29, con una media ponderada de 1.21. El valor en ahorro energético de una magnitud así se ha convertido un factor clave a la hora de competir en el mercado, y permite por ejemplo a Google ser mucho más agresivo a la hora de ofrecer servicios gratuitos que otros competidores que tienen que afrontar costes más elevados.

Además de la virtualización, un amplio abanico de tecnologías que van desde el uso de aire exterior en climas fríos hasta el uso de ordenadores con formas que permitan una mejor evacuación del calor (los denominados "blades" en lugar de los típicos "pizza boxes", entre muchas otras innovaciones) o la centralización de componentes como los sistemas de alimentación ininterrumpida han dado lugar a una carrera por la eficiencia energética que, unida a iniciativas como el incremento de la reciclabilidad de los componentes y el uso de materiales más ecológicos en la fabricación definen la llamada Green IT, tecnología verde. El ratio más habitual utilizado para medir la eficiencia energética es el conocido como PUE (Power Use Efficiency, o Eficiencia en el uso de electricidad), que representa la potencia que hay que suministrar a un centro de datos para llegar a suministrar un vatio al ordenador, y suele oscilar, en centros de datos de construcción antigua, en valores superiores a 2: por cada vatio que llega al ordenador y se convierte en potencia de computación, ha sido necesario suministrar al centro de datos dos vatios, uno de los cuales se ha perdido en refrigeración, elementos de conexión, sistemas de alimentación ininterrumpida, etc. Frente a las intenciones de la Agencia de Protección Ambiental de los Estados Unidos de imponer un PUE inferior a 1.9 para el año 2013, algunas empresas como Google han llegado, en esta carrera por la eficiencia a obtener en sus enormes centros de datos, a valores de PUE de entre 1.13 y 1.29, con una media ponderada de 1.21. El valor en ahorro energético de una magnitud así se ha convertido un factor clave a la hora de competir en el mercado, y permite por ejemplo a Google ser mucho más agresivo a la hora de ofrecer servicios gratuitos que otros competidores que tienen que afrontar costes más elevados.

La evolución de la tecnología, por tanto, nos acerca cada vez más a un mundo en el que la tecnología, tanto a efectos de almacenamiento como de procesamiento, se convierte en una commodity, en algo que proviene de un centro de datos construido seguramente en alguna latitud fría o con disponibilidad de agua utilizable para refrigeración, donde la lucha contra el calentamiento de las máquinas puede llevarse a cabo de una manera más económica. Un ejemplo claro lo constituye de nuevo Google: su red de centros de datos es un complejo entramado de unas treinta y seis localizaciones (en el año 2008), a la que se une otra red secundaria de localizaciones compartidas en régimen de alquiler, que conforman una red completamente distribuida.

Gracias a la tecnologías de virtualización empleadas por la compañía, la carga de cualquiera de esas localizaciones puede ser desplazada de manera sencilla e inmediata a cualquier otra, dando lugar a una red prácticamente líquida, a una capa que trasciende las localizaciones individuales. ¿Dónde está la verdadera ventaja? Dada la estructura de Google, la ventaja no tiene nada que ver con el ofrecer versiones locales, dado que éstas pueden, en un momento dado, estar corriendo sobre cualquier localización física, sino que se produce en términos de costes operativos: existen centros de datos como el de de Saint-Ghislain (Bélgica), que no solamente tratan de reducir el número de aparatos de aire acondicionado, sino que directamente los eliminan por completo. El clima de Saint-Ghislain (entre 18.8ºC y 21.6ºC) permite refrigerar mediante la simple circulación del aire exterior durante una media de trescientos cincuenta y ocho días al año, unido a un sistema de refrigeración por agua que utiliza, en lugar de agua de la traída municipal, la que circula por un canal industrial cercano que es purificada a la entrada del centro de datos (la legislación mediambiental suele prevenir que las industrias devuelvan el agua empleada en procesos de refrigeración a una temperatura mayor a la que tenía cuando fue recogida). Si el tiempo cambia, y llegamos a uno de esos escasos días de más calor en Saint-Ghislain en los que sería preciso utilizar uno de esos inexistentes aparatos de aire acondicionado para refrigerar el centro de datos, la solución consiste en ir apagando ordenadores hasta que el calor generado se reduce lo suficiente, ordenadores cuyas tareas son inmediatamente asumidas por máquinas en otras localizaciones geográficas. Lógicamente, esto conlleva que las localizaciones más interesantes a futuro para la compañía son aquellas en las que el rango de temperaturas resulta más adecuado, y que el hecho de tener muchos centros de datos distribuidos a lo largo de diversas franjas climáticas con diferente estacionalidad permite compensar estos balances.

Pero no es éste el único tipo de balanceo que puede llevarse a cabo: existe también la posibilidad de desplazar carga hacia lugares que puedan aprovechar tarifas más bajas de electricidad, como por ejemplo durante horas nocturnas de bajo consumo, lo que originaría un trasvase constante de recursos de computación entre diferentes zonas horarias siguiendo una estrategia conocida como “follow the moon”. Posibilidades como éstas indican que en un futuro, la mayor parte de los recursos de computación estarán desarrollados por proveedores globales de este tipo capaces de generar arquitecturas globales que aprovechen este tipo de estrategias. Tener un centro de datos corporativo en una empresa normal supondrá un diferencial de coste absurdo, de muy difícil justificación racional. Una forma de entender la transición progresiva a la nube como una simple cuestión de costes, de última línea de la cuenta de resultados, que además en este caso se alinea con una mayor sostenibilidad: a fuerza de evolucionar y perfeccionar la tecnología utilizada en los centros de datos, éstos se han convertido en un negocio suficientemente especializado como para ser desarrollado, lógicamente, por especialistas.